新智元报道

新智元报道

来源:mihaileric

编辑:元子,大明

【新智元导读】Alexa AI机器学习科学家回顾并总结了ACL 2019会议内容,从减少偏见、落地应用、模型整合能力等多个方面对目前NLP领域的发展趋势进行了总结。

本周,在佛罗伦萨举行的ACL 2019上,参会者中有一个人感慨良多,他就是Alexa AI的机器学习科学家Mihail Eric。

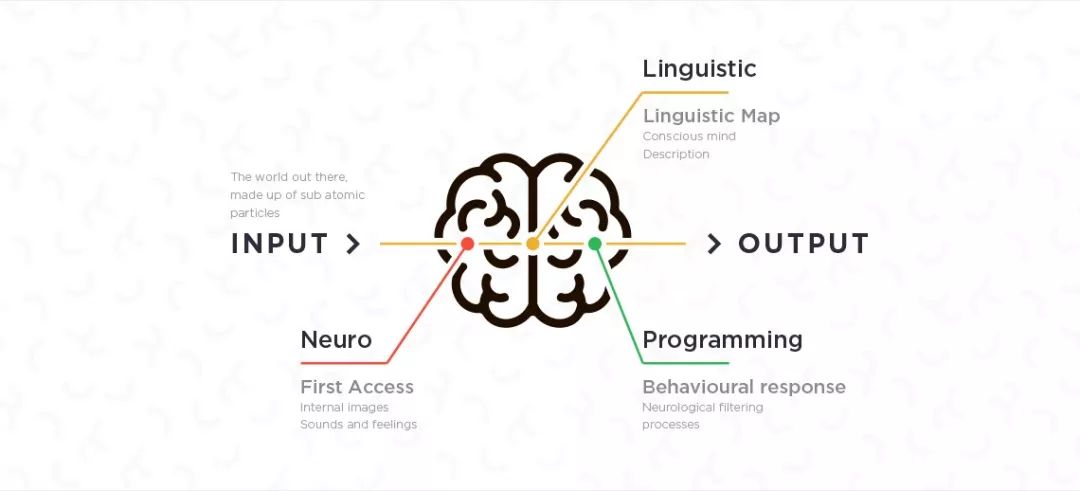

他在Alexa的工作和研究内容与自然语义、会话密切相关。而此次大会可以说聚集了来自世界各地的NLP领域最优秀的研究人员,水准之高无需多言。

参加会议就是这样,总会有一种在知识的湍流中激流勇进的感觉。你身边充斥着论文、演讲、创意和才华横溢的人。犹豫就会浪费,果断又会错过,真是让人左右为难。

不过好在Eric是个善于总结的人。他将自己在ACL 2019一周时间里的所见所闻梳理了出来,从中我们得以更直接的了解NLP领域在2019年的动态和趋势,以及未来的发展方向。

ACL主席周明在开幕致辞中指出,今年的ACL是历史上规模最大的,共提交了2900多份论文,比2018年增加了75%!自然语言处理领域炙手可热,学术和行业热情创历史新高。

然而,全球范围来看,NLP研究的发展极度不平衡,基本上在NLP上的所有突破性成果都集中在美国和中国,这两国在研究水平上远远领先于其他国家和地区。这样的状态容易出现地域偏见的风险,缺乏多样化的观点。

周明根据他在亚太地区的NLP社区经验,指出了一个可能的解决方案,就是在那些代表性不足的地区举办更多的学术会议和活动,这样可以刺激当地NLP研究的积极性。目前也有相关案例,比如在非洲举办的深度学习Indaba活动。

除了地域偏见之外,还有性别偏见。一些论文通过实证研究强调了这些事实。例如,Stanovsky等人证明了四种工业机器翻译系统以及两种当前最先进的学术(SOTA)模型都非常容易出现基于性别偏见的翻译错误。

NLP社区很清楚这个问题。提出了许多有意思的作品来试图解决上述翻译问题,如Kaneko等开发了一种词汇嵌入的去除方法,可以保留非歧视性别相关信息,同时消除陈规定型的性别偏见。

而且今年的ACL还在NLP研讨会上第一次针对性别偏见问题举行了会议,并扩大了NLP研讨会的范围,这些研讨会将研究这些问题的研究人员聚集在一起,提高认识,并促进富有成果的讨论。

当然,NLP社区未来还有很多工作要做,但看到社区采取积极措施来缓解偏见问题令人鼓舞。

NLP研究的当前状态是令人振奋的。

因为NLP领域现在处于技术和应用相融合的阶段,目前开发的模型和工具可以应用在很多场景下,解决许多实际问题,会议上展示的各种NLP应用程序也让这一点变得清晰起来。

在神经网络生成的假新闻成为一大问题的时代,验证叙述内容的真实性正变得越来越重要。hengli Hu的研究建立了一个系统,利用声学和语言特征来识别文本和语音中隐藏的信息,表现超过人类达15%!

在健康领域,Shardlow等人开发了一种神经网络模型,用于通过特定于某些域的短语列表,让医生编写的临床信息对患者而言更具可读性。在相关研究中,Du等人提出了从临床对话中提取症状以及基线模型的任务,以减少初级医生在与临床文献系统交互上所花费的时间。

今年的ACL还有一个专门讨论NLP应用于生物学问题的研讨会。Fauqueur等人提出了从生物医学文献中提取新事实的技术,无需培训数据或手工制作的规则。Rajagopal和Vyas等人通过在大型数据集上预先训练LSTM-CRF模型,然后在低资源语料库上进行微调,在标准数据集上实现21 F1点的改进,从而将语义角色标记系统适应生物过程!

NLP的其他很酷的应用还有包括Zhang等人的研究,该研究提出了电子邮件标题生成的问题(就像Gmail的智能回复,但是用于生成电子邮件标题),从自动和人工评估结果来看,这是个有发展前景的问题模型。

正如神经网络在2011年突然彻底改变了计算机视觉领域,自然语言处理的深度学习的故事同样也是一个“爆炸性和快速增长”的故事。

从2015年到2017年,NLP中的大多数任务都可以通过一个相对简单的公式来解决:通过某种连续的矢量表示嵌入文本输入,编码这些表示,参与编码表示,然后预测任务。Matthew Honnibal在一篇文章中很好地描述了这种形式主义。

虽然在概念上很简单,嵌入,编码,参与,预测公式曾一度几乎不可阻挡的在所有类型的任务上实现SOTA结果,例如机器翻译,问答和自然语言推理等等。

如今,随着强大的预训练表示的出现,使用ELMO,OpenAI GPT和BERT等语言建模目标的某些风格进行训练,这种模型是在庞大的数量上预先训练的使用一些较小的域内语料库对数据进行微调和微调。实际上,这一战略已经成功地在现有的NLP基准测试中取得了巨大的SOTA成果。

Dai和Yang等人寻求进一步推动基于transformer的语言超级模型,极大地提高速度并实现SOTA困惑数量。这个新范式的另一个非常有代表性的工作是Liu和He等人利用基于BERT的架构来领先GLUE基准测试排行榜(在提交时)。

除了这些工作本身,围绕会议的一般性讨论是,如果他们使用像BERT这样的东西,许多架构可以实现几个百分点的改进。那么问题就变成了:这种新范式是否使NLP中的许多建模创新变得无足轻重?

Eric个人观点是否定的。总的来说,仍然有许多工作仍然是未充分探索的,对于推动NLP进展的下一次迭代至关重要。

虽然现有的预训练语言超模型体系结构非常强大,但是从原始文本语料库中进行训练的方式可以鼓励您获得学习的乐趣。换句话说,这类模型学到的东西是相当不受约束的,他们的优越表现可能只是能够在巨大的数据集中发现不同背景下的许多文本序列实例。我们可以通过拓展基础知识来源,提供更多的信息来让NLP模型的能力超出这个范围吗?

ACL有很多论文在试图处理这个问题。比如有研究人员使用类型化实体嵌入和底层知识图对齐来增强BERT表示,让他们的模型在实体类型和关系分类方面胜过BERT。还有人通过KT-NET解决了这个问题,KT-NET使用注意力机制融合来自知识库(如WordNet和NELL)的选定信息,从而在Squad 1.1上刷新了SOTA。

另一篇好文章是Logan等人的论文,此文提出了知识图语言模型,这是一种生成体系结构,可以从与基础上下文相关的知识图中有选择性地复制事实,性能优于强基线语言模型。

虽然将知识融入神经模型确实是一个难题,但从目前的结果来看,似乎很有希望!

众所周知,神经网络属于黑盒模型,为此,要真正理解所学习的决策函数是特别困难的。姑且不论追求这些模型的完全可解释性是否绝对必要,但可以说,对模型内部结构的某种程度的理解可以为未来的架构设计提供有用的信息。ACL上的几篇好文章为理解现有模型提供一些新启示。

塞拉诺团队的研究表明,尽管有时候注意力机制对表明模型结构的概念非常重要,但有些情况下,其他替代性排名指标可能会更有效地解释模型的决策过程。

Jawahar团队则探讨BERT学习的语言结构,证明BERT的层学习丰富的语言信息,如底层的表面特征,中间层的句法特征和顶层的语义特征。作者进一步建议,更深层的网络是学习长距离彼此相关的信息所必需的条件。

还有其他一些文章着力解决模型的可解释性问题。Gehrmann团队开发了一种工具,通过对预测单词标记的模型密度进行可视化,来检测神经网络生成的假文本,检测准确率提高了近20%。Sydorova团队研究了一些事后解释的方法,如问答系统上的LIME,证明某些技术可以帮助人类从几个QA模型中识别出最优秀的那个。

自然语言生成的评估的概念仍然是一个非常有争议的问题,因此这种重新思考是值得提倡的。

Maxime Peyrard证明,在评估某些评分范围内的表现时,某些自动评估汇总指标是不一致的。Clark团队根据句子移动的相似性提出了一个新的生成文本评估指标,与标准ROUGE相比,该指标与人类判断的相关性更强。

模型生成的文本往往会受到事实错误和虚假陈述的影响。Falke团队研究了是否可以将自然语言推理系统用于重新排列输出,作为处理这一问题的方法。他们发现,“开箱即用”的NLI系统还不足以适应下游任务,并提供了一些必要的工具,让这些推理系统达到所需的性能。

Maxime Peyrard还进行了更为基础的研究工作,对冗余、相关性和信息性等某些概念进行了理论上严格的理论定义。

除了评估相关的工作之外,Sankar团队对传统的递归网络和基于transformer的seq2seq对话模型可以从对话历史中学习的假设提出了质疑。特别是,他们表明这些模型对应用于背景的某些扰动不是非常敏感,从而对对话自然语言生成器的效果提出了挑战。

我们经常使用基准测试来衡量任务的表现和性能改进,而这些模型中许多模型已经接近或超过了这些现有NLP基准测试的人类表现。那么我们怎么办?

这是Zellers团队提出的问题。在早期的研究中,他们已经面向常识NLP的问题引入了一个挑战数据集,但在发布之后不久就发现,BERT已经达到了接近人类的表现。为了解决这个问题,作者提出了一个后续数据集,该数据集是使用“对抗性过滤”的技术开发,用于选择BERT和其他模型难以回答的示例。在此过程中,他们大大增加了基准的复杂度。

BERT当然不是完美的。Nangia等人的一项研究表明,基于BERT的模型在稀缺资源句子分类任务上的表现并不好,并提出了名为SuperGLUE的后续自然语言理解基准模型,专门用于评估这类任务。

McCoy等人的另一项研究表明,用于自然语言推理的BERT模型学习的是非常简单的句法启发式方法,这些方法不能很好地适用于为其他任务实例。他们还发布了一个评估集,以确定模型是否采用这些启发式算法,解决更一般的推理问题。

总而言之,我的感觉是,目前的大部分模型仍在解决数据集问题,而不是处理实际任务。我们构建的模型在选择并利用特定于数据集的偏差方面效果惊人。在此过程中,我们制定的评估指标描绘出了具有相当误导性的场景。这让我想起了古德哈特定律:当手段变成了目标,它就不再是一个好的衡量标准。那么我们如何继续前进呢?

鉴于这些评估标准是自然语言任务的代理,而且在模型开发进展迅速的情况下,想让基准保持不变似乎是不合理的。相反,我发现特别有希望的一条路是,开发一套难度不断增加的、不断变化的动态基准,每个基准都能够进一步推动自然语言能力的提升。也许这套基准的性能极限,这就在机器中实现人类级的NLP表现。

从这次ACL的论文来看,NLP的领域正在蓬勃发展!社区正在处于一个非常激动人心的时期,也有许多有前途的研究。尽管过去的一年NLP领域取得了实质性进展,但仍有许多突出的挑战和未解决的问题需要解决。

— 完 —

为您推荐

只用2页纸,北大数学校友攻破计算机30年难题!过程浅显直白,看懂仅需线性代数基础

Nature发文:避开机器学习三大「坑」

如何利用Python开发人工智能入门项目

如何写出让同事无法维护的代码?

【微软】AI-神经网络基本原理简明教程

本篇文章来源于: 深度学习这件小事

本文为原创文章,版权归知行编程网所有,欢迎分享本文,转载请保留出处!

内容反馈