转自 | 新智元

,或颠倒RL (Upside Down RL, UDRL)。标准RL预测奖励,而UDRL使用奖励作为任务定义的输入,以及时间范围的表示和历史数据以及可期的未来数据的其他可计算函数。

,或颠倒RL (Upside Down RL, UDRL)。标准RL预测奖励,而UDRL使用奖励作为任务定义的输入,以及时间范围的表示和历史数据以及可期的未来数据的其他可计算函数。 是完全不同的。它根本不预测奖励。相反,它将奖励作为输入。更准确地说,

是完全不同的。它根本不预测奖励。相反,它将奖励作为输入。更准确地说, 系统以期望奖励和时间范围的形式执行命令,例如:“在这么长的时间内获得这么多的奖励。”通过与环境进行简单交互,它能通过梯度下降来学习,将这种类型的自生成命令映射到相应的动作概率。从这种自学的知识可以推断出解决新问题的方法,例如:“用更少的时间获得更多的奖励。”

系统以期望奖励和时间范围的形式执行命令,例如:“在这么长的时间内获得这么多的奖励。”通过与环境进行简单交互,它能通过梯度下降来学习,将这种类型的自生成命令映射到相应的动作概率。从这种自学的知识可以推断出解决新问题的方法,例如:“用更少的时间获得更多的奖励。”

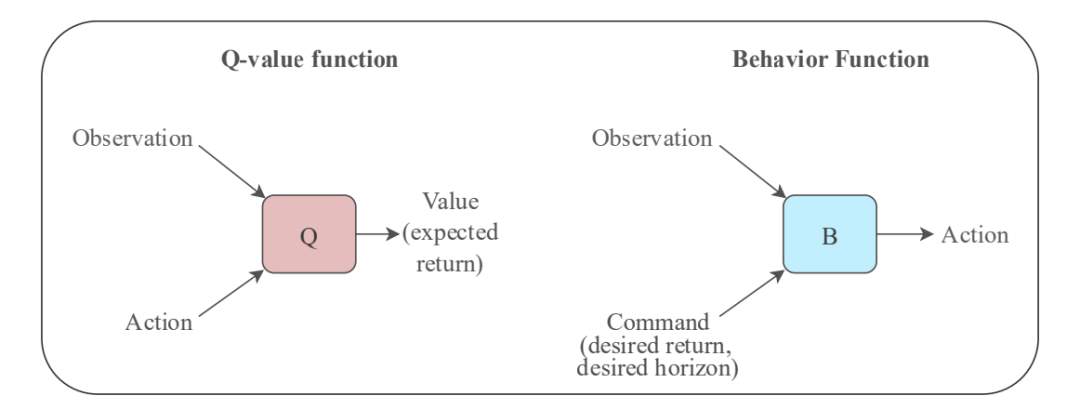

中的行为函数(B)之间的一个关键区别是,行为和回报的角色是反过来的。此外,B可以有其他的命令输入,如所需的状态或实现所需回报的时间范围。

中的行为函数(B)之间的一个关键区别是,行为和回报的角色是反过来的。此外,B可以有其他的命令输入,如所需的状态或实现所需回报的时间范围。 agent可以在一次终身试验中与其环境交互。在给定的时间内,行为的历史和向量值的成本(例如,时间、精力、痛苦和奖励信号)和其他到目前为止的观察结果包含了agent可以知道的有关其自身和环境当前状态的所有信息。现在,它要展望未来的极限,试图在到达极限之前获得大量回报。

agent可以在一次终身试验中与其环境交互。在给定的时间内,行为的历史和向量值的成本(例如,时间、精力、痛苦和奖励信号)和其他到目前为止的观察结果包含了agent可以知道的有关其自身和环境当前状态的所有信息。现在,它要展望未来的极限,试图在到达极限之前获得大量回报。 实验中的具体

实验中的具体 实现,并给出了显著的实验结果。

实现,并给出了显著的实验结果。

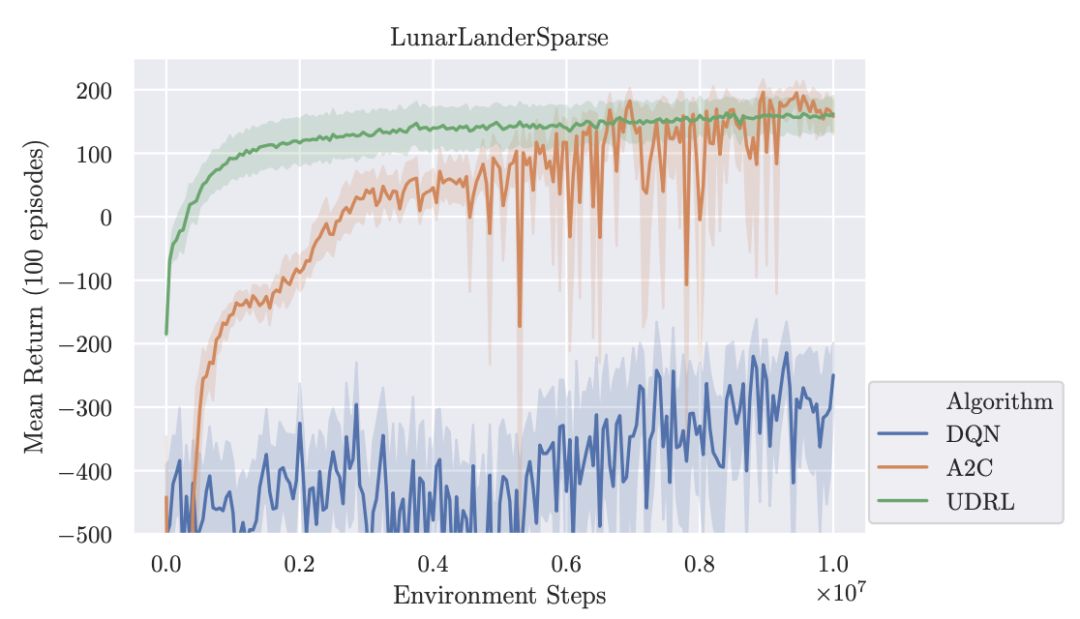

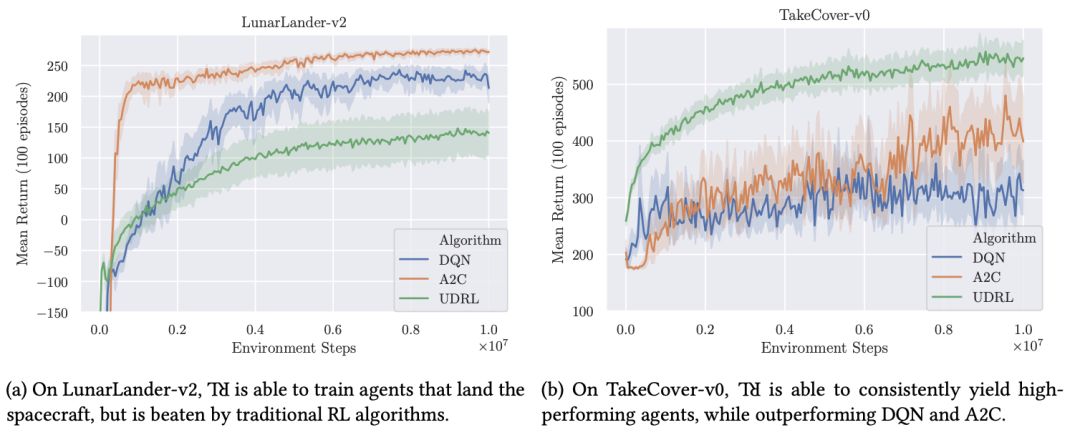

的实际可行性,并将其与两个著名的传统RL算法:Deep Q-Networks (DQN)和Advantage Actor-Critic (A2C)进行比较。

的实际可行性,并将其与两个著名的传统RL算法:Deep Q-Networks (DQN)和Advantage Actor-Critic (A2C)进行比较。

的学习速度更快、更一致。

的学习速度更快、更一致。 在这项任务的表现比DQN和A2C要差。但对单个agent的检查表明,它能够持续地训练成功着陆的agent,但是有些agent能快速学习并获得类似于A2C/DQN的回报时,其他agent则较低回报时停滞不前。我们推测这种环境比较适合TD学习,因为它的奖励结构比较密集,最后奖励信号比较大。

在这项任务的表现比DQN和A2C要差。但对单个agent的检查表明,它能够持续地训练成功着陆的agent,但是有些agent能快速学习并获得类似于A2C/DQN的回报时,其他agent则较低回报时停滞不前。我们推测这种环境比较适合TD学习,因为它的奖励结构比较密集,最后奖励信号比较大。 轻松地超越了DQN和A2C,证明了它对高维控制问题的适用性。

轻松地超越了DQN和A2C,证明了它对高维控制问题的适用性。<section style="margin-right: 8px;margin-left: 8px;max-width: 100%;white-space: normal;color: rgb(0, 0, 0);font-family: -apple-system-font, system-ui, "Helvetica Neue", "PingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;letter-spacing: 0.544px;text-align: center;widows: 1;line-height: 1.75em;box-sizing: border-box !important;overflow-wrap: break-word !important;"><strong style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;letter-spacing: 0.5px;font-size: 14px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><strong style="max-width: 100%;font-size: 16px;letter-spacing: 0.544px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;letter-spacing: 0.5px;box-sizing: border-box !important;overflow-wrap: break-word !important;">—</span></strong>完<strong style="max-width: 100%;font-size: 16px;letter-spacing: 0.544px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;letter-spacing: 0.5px;font-size: 14px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><strong style="max-width: 100%;font-size: 16px;letter-spacing: 0.544px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;letter-spacing: 0.5px;box-sizing: border-box !important;overflow-wrap: break-word !important;">—</span></strong></span></strong></span></strong></section><section style="max-width: 100%;white-space: normal;font-family: -apple-system-font, system-ui, "Helvetica Neue", "PingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;letter-spacing: 0.544px;text-align: center;widows: 1;color: rgb(255, 97, 149);box-sizing: border-box !important;overflow-wrap: break-word !important;"><section powered-by="xiumi.us" style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;"><section style="margin-top: 15px;margin-bottom: 25px;max-width: 100%;opacity: 0.8;box-sizing: border-box !important;overflow-wrap: break-word !important;"><section style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;"><section style="max-width: 100%;letter-spacing: 0.544px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><section powered-by="xiumi.us" style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;"><section style="margin-top: 15px;margin-bottom: 25px;max-width: 100%;opacity: 0.8;box-sizing: border-box !important;overflow-wrap: break-word !important;"><section style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;"><section style="margin-right: 8px;margin-bottom: 15px;margin-left: 8px;padding-right: 0em;padding-left: 0em;max-width: 100%;color: rgb(127, 127, 127);font-family: sans-serif;font-size: 12px;line-height: 25.5938px;letter-spacing: 3px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;color: rgb(0, 0, 0);box-sizing: border-box !important;overflow-wrap: break-word !important;"><strong style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;font-size: 16px;font-family: 微软雅黑;caret-color: red;box-sizing: border-box !important;overflow-wrap: break-word !important;">为您推荐</span></strong></span></section><p style="margin-right: 8px;margin-bottom: 5px;margin-left: 8px;padding-right: 0em;padding-left: 0em;max-width: 100%;min-height: 1em;color: rgb(127, 127, 127);font-family: sans-serif;font-size: 12px;line-height: 1.75em;letter-spacing: 0px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="font-size: 14px;">博士最“惨”能到什么程度?</span><br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /></p><p style="margin-right: 8px;margin-bottom: 5px;margin-left: 8px;padding-right: 0em;padding-left: 0em;max-width: 100%;min-height: 1em;color: rgb(127, 127, 127);font-family: sans-serif;font-size: 12px;line-height: 1.75em;letter-spacing: 0px;box-sizing: border-box !important;overflow-wrap: break-word !important;">“12306”的架构到底有多牛逼?<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /></p><p style="margin-right: 8px;margin-bottom: 5px;margin-left: 8px;padding-right: 0em;padding-left: 0em;max-width: 100%;min-height: 1em;color: rgb(127, 127, 127);font-family: sans-serif;font-size: 12px;line-height: 1.75em;letter-spacing: 0px;box-sizing: border-box !important;overflow-wrap: break-word !important;">网传饶毅举报多位学者论文造假?官方回应了<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /></p><p style="margin-right: 8px;margin-bottom: 5px;margin-left: 8px;padding-right: 0em;padding-left: 0em;max-width: 100%;min-height: 1em;color: rgb(127, 127, 127);font-family: sans-serif;font-size: 12px;line-height: 1.75em;letter-spacing: 0px;box-sizing: border-box !important;overflow-wrap: break-word !important;">阿里如何抗住90秒100亿?看这篇你就明白了!<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /></p><p style="margin-right: 8px;margin-bottom: 5px;margin-left: 8px;padding-right: 0em;padding-left: 0em;max-width: 100%;min-height: 1em;color: rgb(127, 127, 127);font-family: sans-serif;font-size: 12px;line-height: 1.75em;letter-spacing: 0px;box-sizing: border-box !important;overflow-wrap: break-word !important;">深度学习必懂的13种概率分布</p></section></section></section></section></section></section></section></section>

本篇文章来源于: 深度学习这件小事

本文为原创文章,版权归知行编程网所有,欢迎分享本文,转载请保留出处!

内容反馈