如果测试集不靠谱,那测出来的模型性能会靠谱吗?MIT研究了10个流行的CV的数据集,平均测试集的错误率超过3.4%,最多的竟然错误超10%。

「clean code」是机器学习的基础,在公开的数据集取得更好的效果也是发表论文的基础。

众所周知的是,公开数据集并不都是完美的,或多或少都存在标签错误的问题。之前的工作主要关注「训练数据集」中的错误,忽视了「测试数据集」的错误。

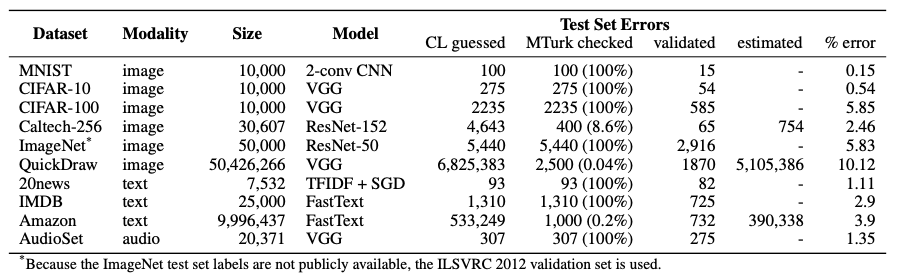

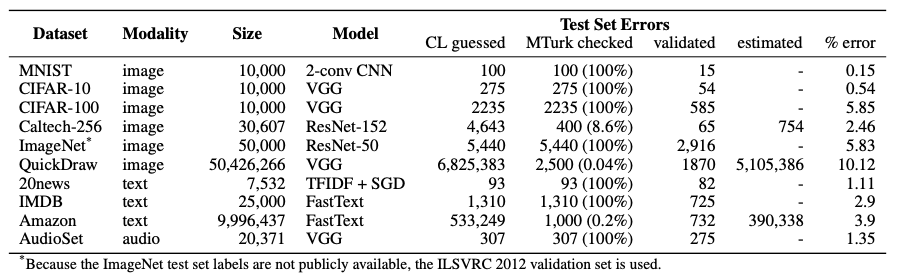

MIT在arxiv上传了一篇论文,研究了10个流行的数据集,借助Amazon的众包平台Machine Turk来检验错误率。

通过算法识别并人工验证,发现确实普遍存在标签错误,10个数据集的平均错误率为3.4%

即使是久经沙场,被无数论文作为基准测试过的MNIST数据集,在测试集中也包含15个(人工验证过的)标签错误。

不过大部分错误都属于有争议的结果,手写体写出来和看起来确实存在较大差距,例如0和6。

通过自然语言来定义标签,一个问题就是语言的「歧义性」。

下面三张标签中,图一过于抽象,并没有看出来是大象或是什么其他物种。

第二幅图被标注为「碗」,而被纠正为「茶杯」。cup与bowl之间的区别在于用途、大小。而根据图中比例来说,并无法分辨是碗还是杯子。

图三小编觉得更像是桌子,一个带花纹的桌子,可能纠正错了。

QuickDraw共包含了五千万幅画,其中抽样测试集错误率约为10%,也就是说五百万个样例都是错误的。

例如下图中,眼睛被标注为了老虎,灯泡被标注为鳄鱼皮。

第三幅图笔画过于简单,想象空间比较大,数据集给出的标签是落地灯,众包人员认为是回旋镖,但还有许多其他的答案,例如大雁或者其他的具有翅膀的动物。

还有其他离谱的标注,天使被标注成三角形,鸟标注为火炉,苹果标注为衬衫,差的有点大吧?只能说标注人员脑洞开的真的很大!

ImageNet的错误分类有许多是动物类的,需要标注人员具有专业知识,能够准确区分各个动物。

跑车和赛车之间的区别还是比较大的,图一难道不是「玩具车」?

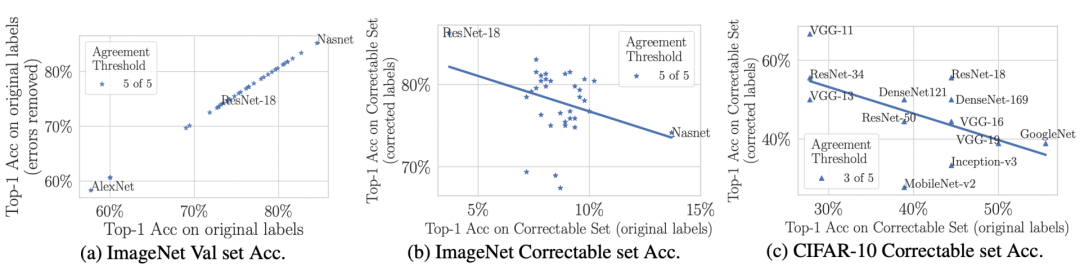

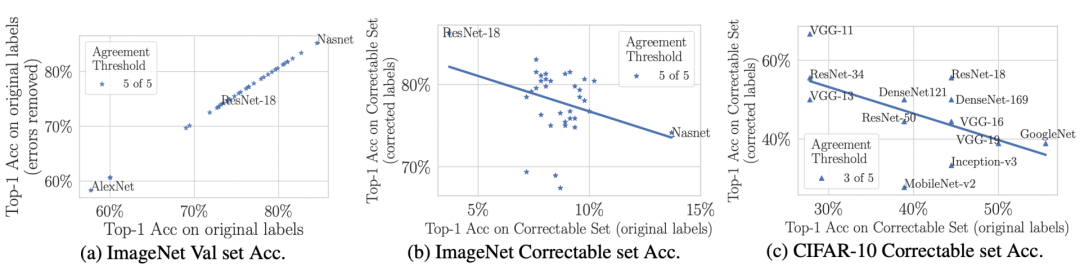

图(a)显示,移除更多的错误标签,能够线性地提高ResNet-18的准确率。

图(b)和图(c)说明,当纠正更多的错误标签时,准确率也会上升。

当数据集中错误标签被纠正后,不同模型之间的排名也会发生较大变化。

人工标注是一个既客观又主观的事情,人在做图像识别任务的时候,也无法达到100%的准确率,错误无可避免。

训练集的错误标签同样会影响到模型在测试集上的表现,错误的标记可能会导致科研人员得出模型在现实世界中性能更佳的错误结论,从而破坏了机器学习系统的基准测试结果。

如何建立一个可依赖的公开数据库,或依赖半监督算法来有效清洗数据,也许是下一步研究方向。

内容反馈