来自 | 知乎 作者 | 陈琛

-

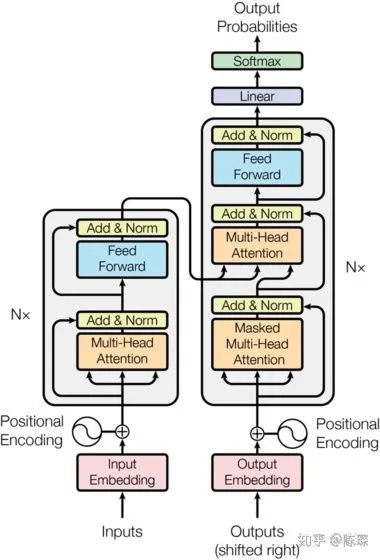

整体架构描述

-

Input & Output Embedding

-

OneHot Encoding

-

Word Embedding

-

Positional Embedding

-

Input short summary

-

Encoder

-

Encoder Sub-layer 1: Multi-Head Attention Mechanism

-

Step 1

-

Step 2

-

Step 3

-

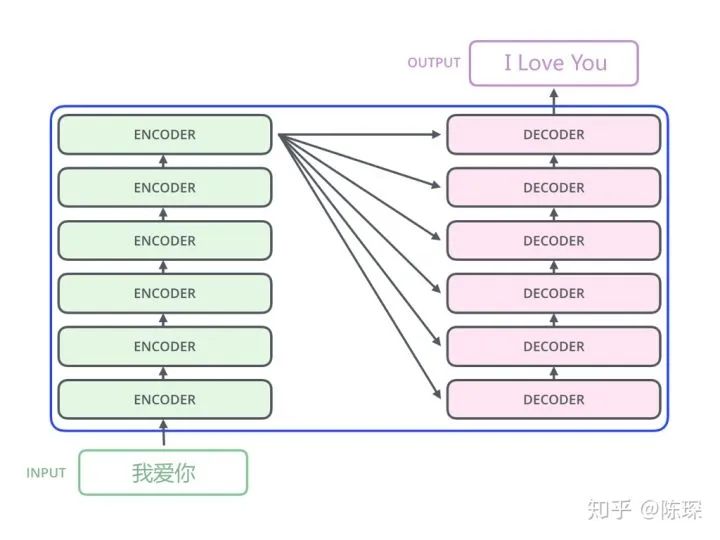

Encoder Sub-layer 2: Position-Wise fully connected feed-forward

-

Encoder short summary

-

Decoder

-

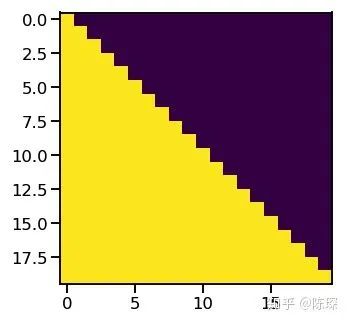

Diff_1:“masked” Multi-Headed Attention

-

Diff_2:encoder-decoder multi-head attention

-

Diff_3:Linear and Softmax to Produce Output Probabilities

-

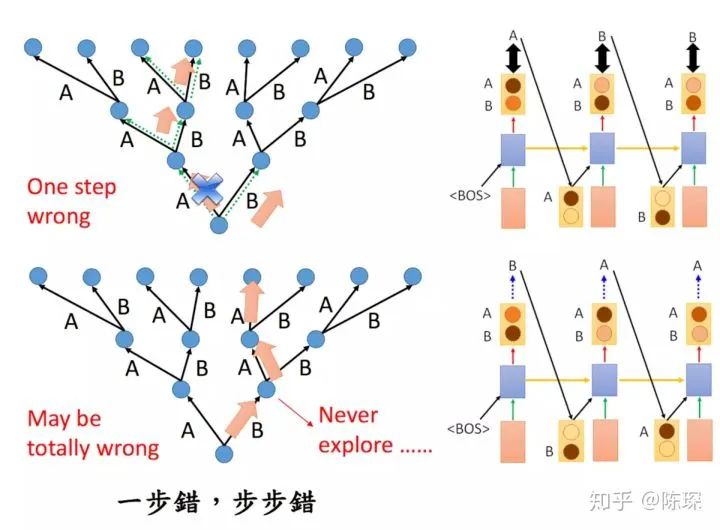

greedy search

-

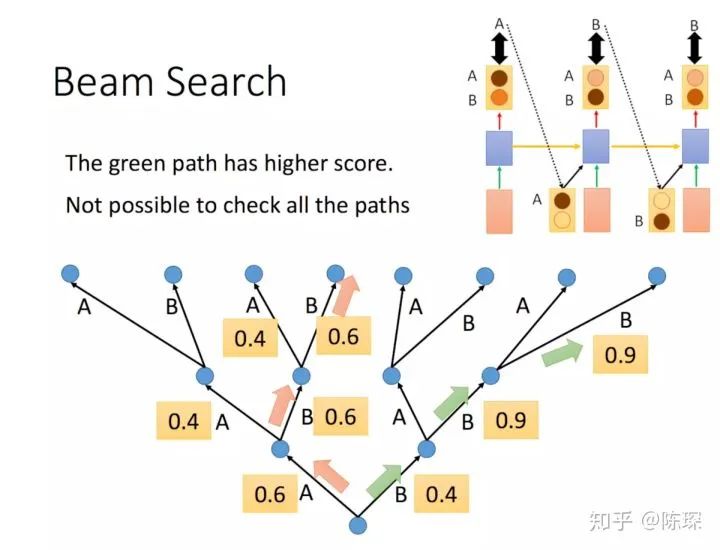

beam search

-

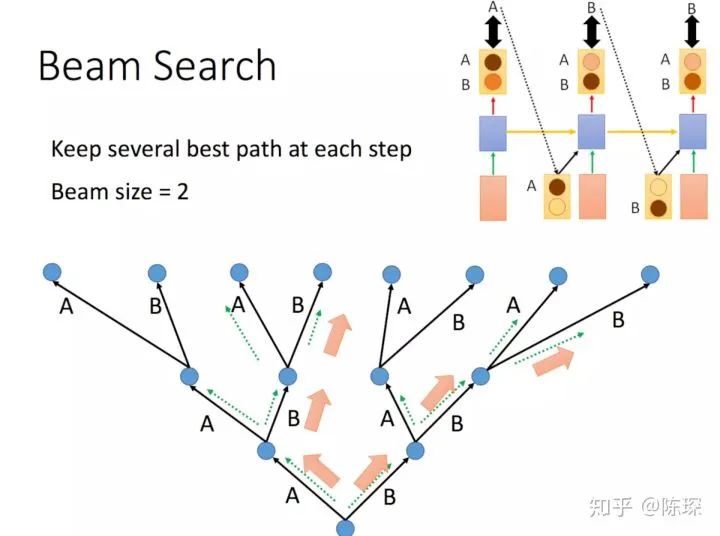

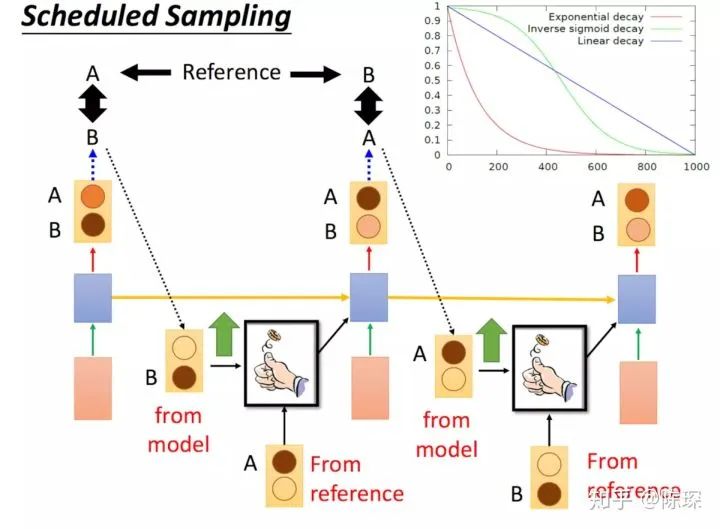

Scheduled Sampling

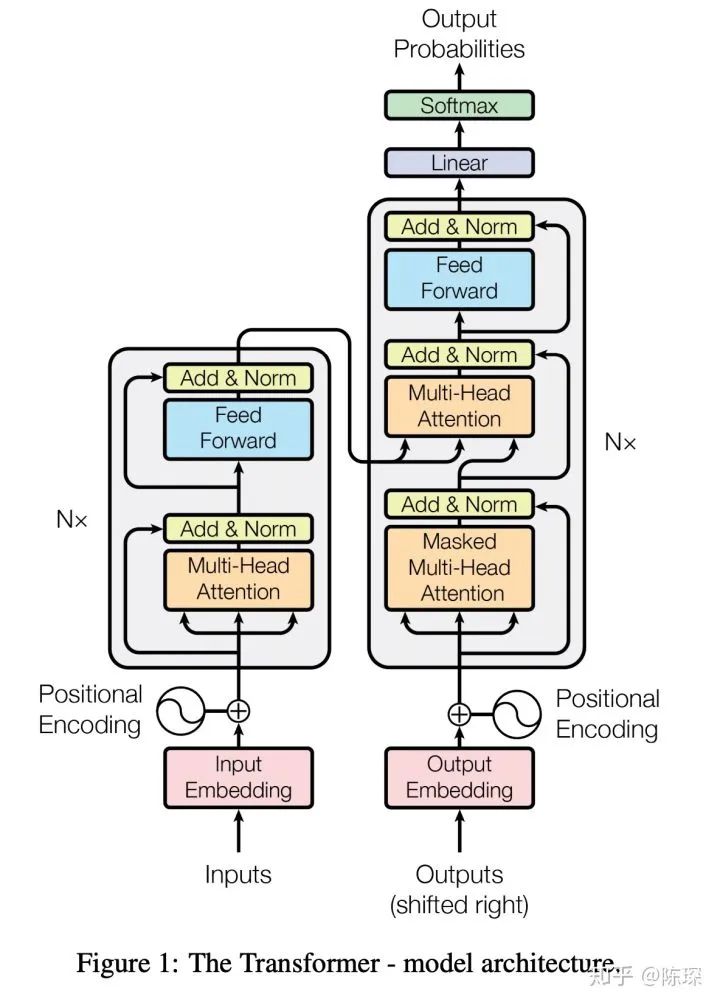

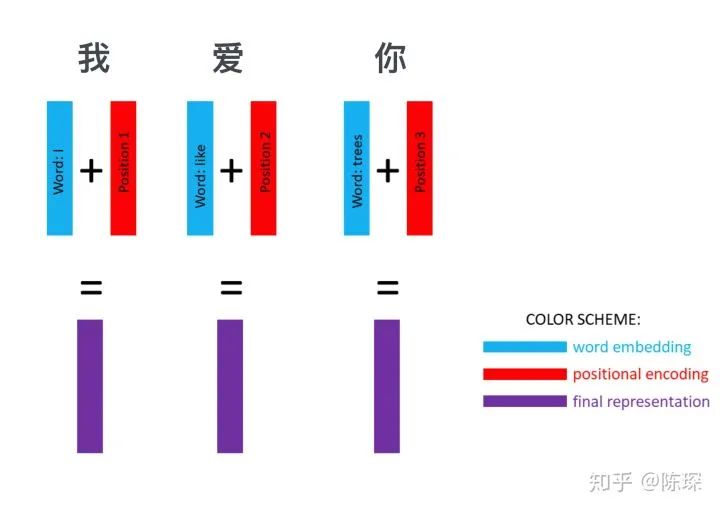

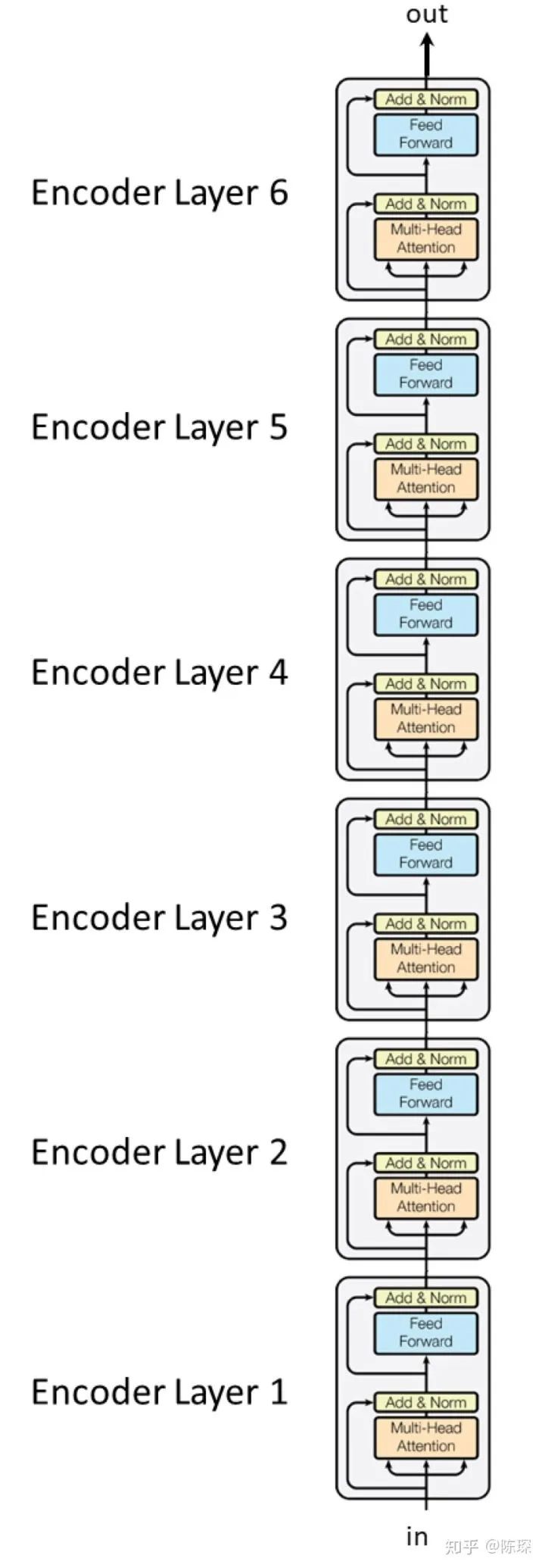

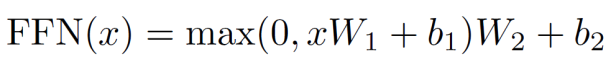

0.模型架构

-

Embedding 部分

-

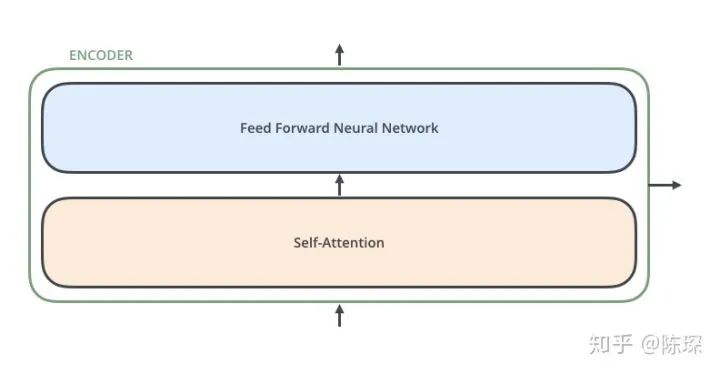

Encoder 部分

-

Decoder 部分

1. 对 Input 和 Output 进行 representation

1.1 对 Input 的 represent

1.2 word embedding

-

使用 pre-trained 的 embeddings 并固化,这种情况下实际就是一个 lookup table。

-

对其进行随机初始化(当然也可以选择 pre-trained 的结果),但设为 trainable。这样在 training 过程中不断地对 embeddings 进行改进。

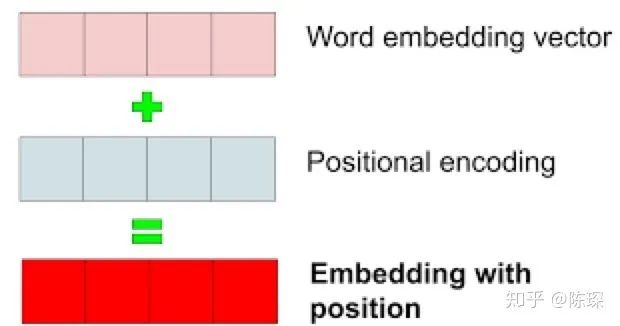

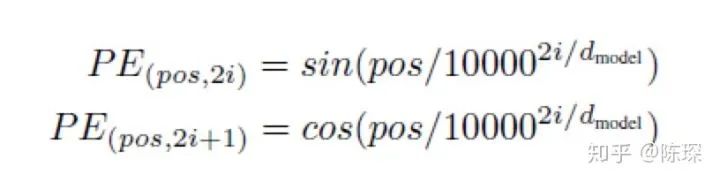

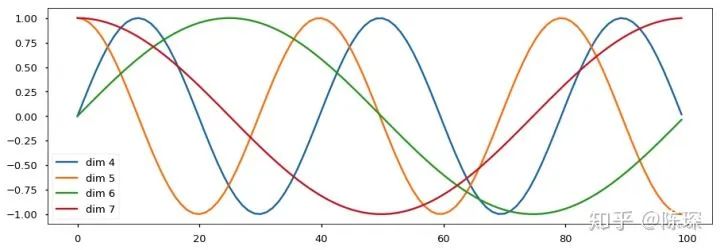

d_model)1.3 Positional Embedding

-

通过训练学习 positional encoding 向量

-

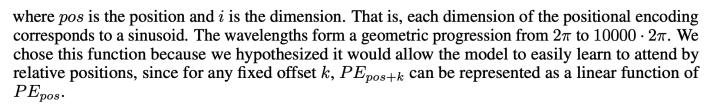

使用公式来计算 positional encoding向量

-

pos 指的是这个 word 在这个句子中的位置

-

i指的是 embedding 维度。比如选择 d_model=512,那么i就从1数到512

dropout(x)

1.4 Input 小总结

-

nbatches 指的是定义的 batch_size

-

L 指的是 sequence 的长度,(比如“我爱你”,L = 3)

-

512 指的是 embedding 的 dimension

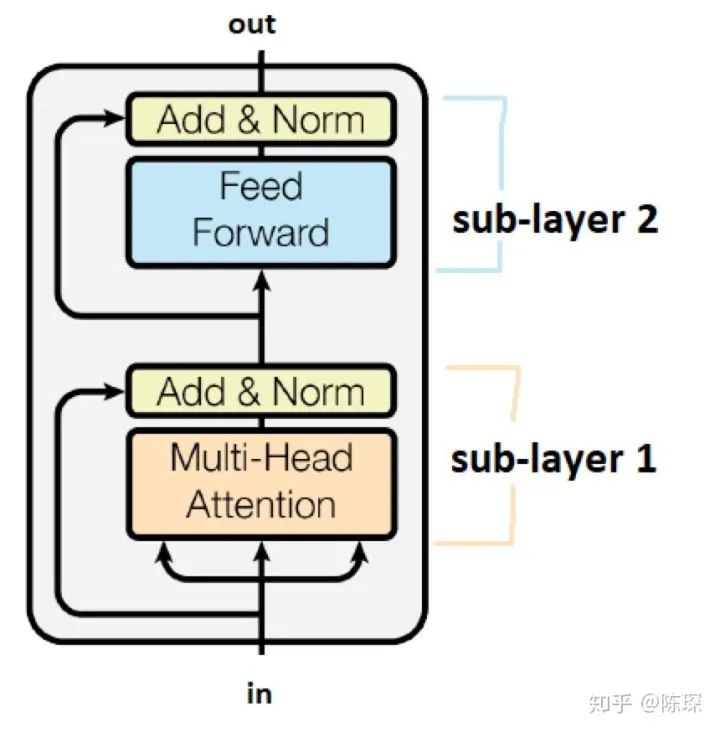

2. Encoder

-

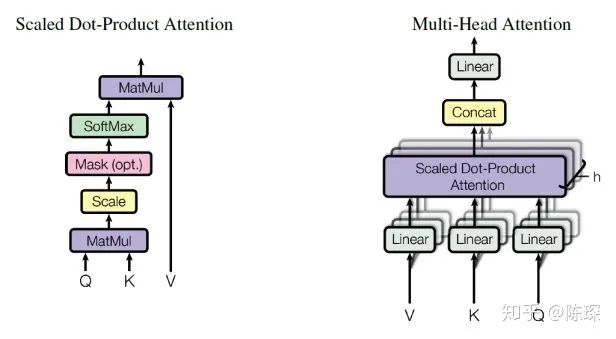

第一个是 ”multi-head self-attention mechanism“

-

第二个是 ”simple,position-wise fully connected feed-forward network“

feed_forward)-

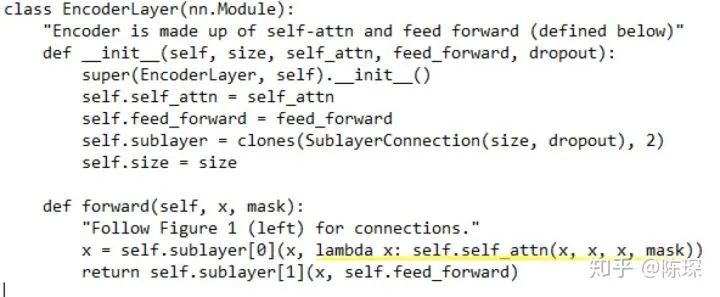

class “Encoder” 将 <layer> 堆叠N次。是 class “EncoderLayer” 的实例。

-

“EncoderLayer” 初始化需要指定<size>,<self_attn>,<feed_forward>,<dropout>:

-

<size> 对应 d_model,论文中为512

-

<self_attn> 是 class MultiHeadedAttention 的实例,对应sub-layer 1

-

<feed_forward> 是 class PositionwiseFeedForward 的实例,对应sub-layer 2

-

<dropout> 对应 dropout rate

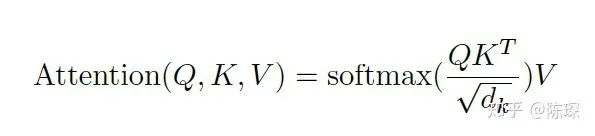

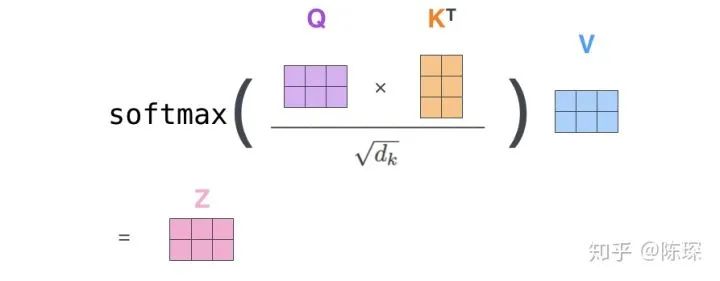

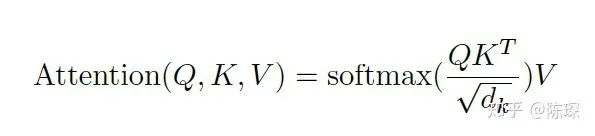

2.1 Encoder Sub-layer 1: Multi-Head Attention Mechanism

我们把 attention 机制的输入定义为 x。x 在 Encoder 的不同位置,含义有所不同。在 Encoder 的开始,x 的含义是句子的 representation。在 EncoderLayer 的各层中间,x 代表前一层 EncoderLayer 的输出。

-

key = linear_k(x)

-

query = linear_q(x)

-

value = linear_v(x)

](x)-

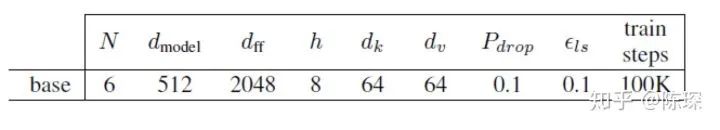

<h> = 8,即 “heads” 的数目。在 Transformer 的 base model 中有8 heads

-

<d_model> = 512

-

<dropout> = dropout rate = 0.1

-

nbatches 对应 batch size

-

L 对应 sequence length ,512 对应 d_mode

-

“key” 和 “value” 的 shape 也为 [nbatches, L, 512]

-

对 “query”,“key”和“value”进行 linear transform ,他们的 shape 依然是[nbatches, L, 512]。

-

对其通过 view() 进行 reshape,shape 变成 [nbatches, L, 8, 64]。这里的h=8对应 heads 的数目,d_k=64 是 key 的维度。

-

transpose 交换 dimension1和2,shape 变成 [nbatches, 8, L 64]。

matmul(p_attn, value), p_attn

2.2 Encoder Sub-layer 2: Position-Wise fully connected feed-forward network

w_1(x))))2.3 Encoder short summary

-

SubLayer-1 做 Multi-Headed Attention

-

SubLayer-2 做 feedforward neural network

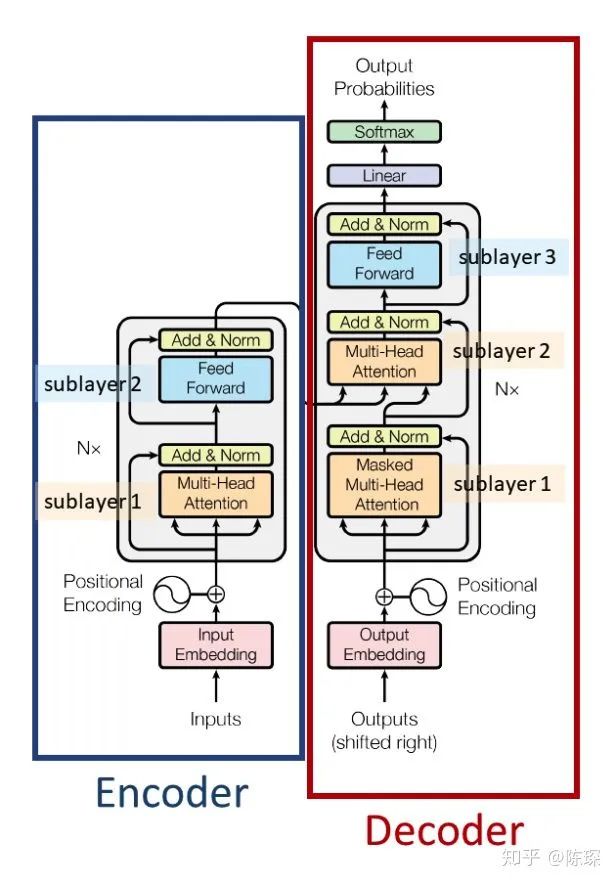

3. The Decoder

-

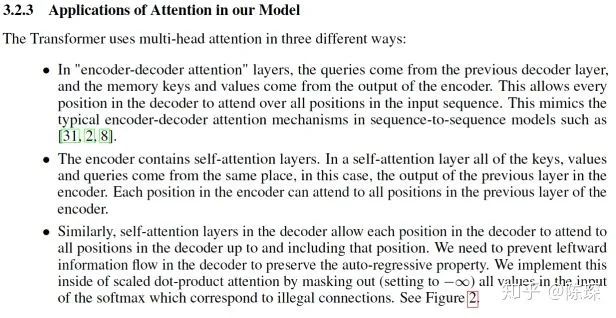

Diff_1:Decoder SubLayer-1 使用的是 “masked” Multi-Headed Attention 机制,防止为了模型看到要预测的数据,防止泄露。

-

Diff_2:SubLayer-2 是一个 encoder-decoder multi-head attention。

-

Diff_3:LinearLayer 和 SoftmaxLayer 作用于 SubLayer-3 的输出后面,来预测对应的 word 的 probabilities 。

3.1 Diff_1 : “masked” Multi-Headed Attention

)3.2 Diff_2 : encoder-decoder multi-head attention

feed_forward)

3.3 Diff_3 : Linear and Softmax to Produce Output Probabilities

-

给 decoder 输入 encoder 对整个句子 embedding 的结果 和一个特殊的开始符号 </s>。decoder 将产生预测,在我们的例子中应该是 ”I”。

-

给 decoder 输入 encoder 的 embedding 结果和 “</s>I”,在这一步 decoder 应该产生预测 “Love”。

-

给 decoder 输入 encoder 的 embedding 结果和 “</s>I Love”,在这一步 decoder 应该产生预测 “China”。

-

给 decoder 输入 encoder 的 embedding 结果和 “</s>I Love China”, decoder应该生成句子结尾的标记,decoder 应该输出 ”</eos>”。

-

然后 decoder 生成了 </eos>,翻译完成。

)

<pre style="max-width: 100%;letter-spacing: 0.544px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><p style="max-width: 100%;white-space: normal;color: rgb(0, 0, 0);font-family: -apple-system-font, system-ui, "Helvetica Neue", "PingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;letter-spacing: 0.544px;widows: 1;line-height: 1.75em;margin-left: 0px;margin-right: 0px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><strong style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;letter-spacing: 0.5px;font-size: 14px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><strong style="max-width: 100%;font-size: 16px;letter-spacing: 0.544px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;letter-spacing: 0.5px;box-sizing: border-box !important;overflow-wrap: break-word !important;">—</span></strong>完<strong style="max-width: 100%;font-size: 16px;letter-spacing: 0.544px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;letter-spacing: 0.5px;font-size: 14px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><strong style="max-width: 100%;font-size: 16px;letter-spacing: 0.544px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;letter-spacing: 0.5px;box-sizing: border-box !important;overflow-wrap: break-word !important;">—</span></strong></span></strong></span></strong></p><section style="max-width: 100%;white-space: normal;font-family: -apple-system-font, system-ui, "Helvetica Neue", "PingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;letter-spacing: 0.544px;widows: 1;box-sizing: border-box !important;overflow-wrap: break-word !important;"><section powered-by="xiumi.us" style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;"><section style="margin-top: 15px;margin-bottom: 25px;max-width: 100%;opacity: 0.8;box-sizing: border-box !important;overflow-wrap: break-word !important;"><section style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;"><section style="max-width: 100%;letter-spacing: 0.544px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><section powered-by="xiumi.us" style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;"><section style="margin-top: 15px;margin-bottom: 25px;max-width: 100%;opacity: 0.8;box-sizing: border-box !important;overflow-wrap: break-word !important;"><section style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;"><p style="margin-bottom: 15px;padding-right: 0em;padding-left: 0em;max-width: 100%;color: rgb(127, 127, 127);font-size: 12px;font-family: sans-serif;line-height: 25.5938px;letter-spacing: 3px;margin-left: 0px;margin-right: 0px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;color: rgb(0, 0, 0);box-sizing: border-box !important;overflow-wrap: break-word !important;"><strong style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;font-size: 16px;font-family: 微软雅黑;caret-color: red;box-sizing: border-box !important;overflow-wrap: break-word !important;">为您推荐</span></strong></span></p><section style="margin-bottom: 5px;padding-right: 0em;padding-left: 0em;max-width: 100%;min-height: 1em;color: rgb(127, 127, 127);font-size: 12px;font-family: sans-serif;line-height: 1.75em;letter-spacing: 0px;margin-left: 0px;margin-right: 0px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;font-size: 14px;box-sizing: border-box !important;overflow-wrap: break-word !important;">人工智能领域最具影响力的十大女科学家</span><br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /></section><section style="margin-bottom: 5px;max-width: 100%;margin-left: 0px;margin-right: 0px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;-webkit-tap-highlight-color: rgba(0, 0, 0, 0);cursor: pointer;font-size: 14px;box-sizing: border-box !important;overflow-wrap: break-word !important;">MIT最新深度学习入门课,安排起来!</span></section><section style="margin-bottom: 5px;padding-right: 0em;padding-left: 0em;max-width: 100%;min-height: 1em;font-family: sans-serif;line-height: 1.75em;letter-spacing: 0px;margin-left: 0px;margin-right: 0px;box-sizing: border-box !important;overflow-wrap: break-word !important;">五分钟了解机器学习十大算法</section><section style="margin-bottom: 5px;padding-right: 0em;padding-left: 0em;max-width: 100%;min-height: 1em;font-family: sans-serif;line-height: 1.75em;letter-spacing: 0px;margin-left: 0px;margin-right: 0px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;color: rgb(87, 107, 149);box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;font-size: 14px;box-sizing: border-box !important;overflow-wrap: break-word !important;">图深度学习入门难?这篇教程帮你理清楚了脉络</span></span><br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /></section><section style="margin-bottom: 5px;padding-right: 0em;padding-left: 0em;max-width: 100%;min-height: 1em;color: rgb(127, 127, 127);font-size: 12px;font-family: sans-serif;line-height: 1.75em;letter-spacing: 0px;margin-left: 0px;margin-right: 0px;box-sizing: border-box !important;overflow-wrap: break-word !important;"><span style="max-width: 100%;font-size: 14px;box-sizing: border-box !important;overflow-wrap: break-word !important;">我为什么鼓励你读计算机领域的博士?</span><br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /></section></section></section></section></section></section></section></section></section>

本篇文章来源于: 深度学习这件小事

本文为原创文章,版权归知行编程网所有,欢迎分享本文,转载请保留出处!

内容反馈